加州大学的科研团队拆了一台笔记本电脑(MacBook)的处理器,装在了一只机械狗身上。

消息一出,网友们纷纷表示:这难道是长了4条腿的MacBook?

不难看出,这只狗可以轻轻松松的越过面前的树干。

狗背上的那个白盒子,就是MacBook拆下来的处理器——里面搭载的是苹果的M1芯片,运行着加州大学的最新研究—— 一种全新的神经体积记忆架构(NVM)。

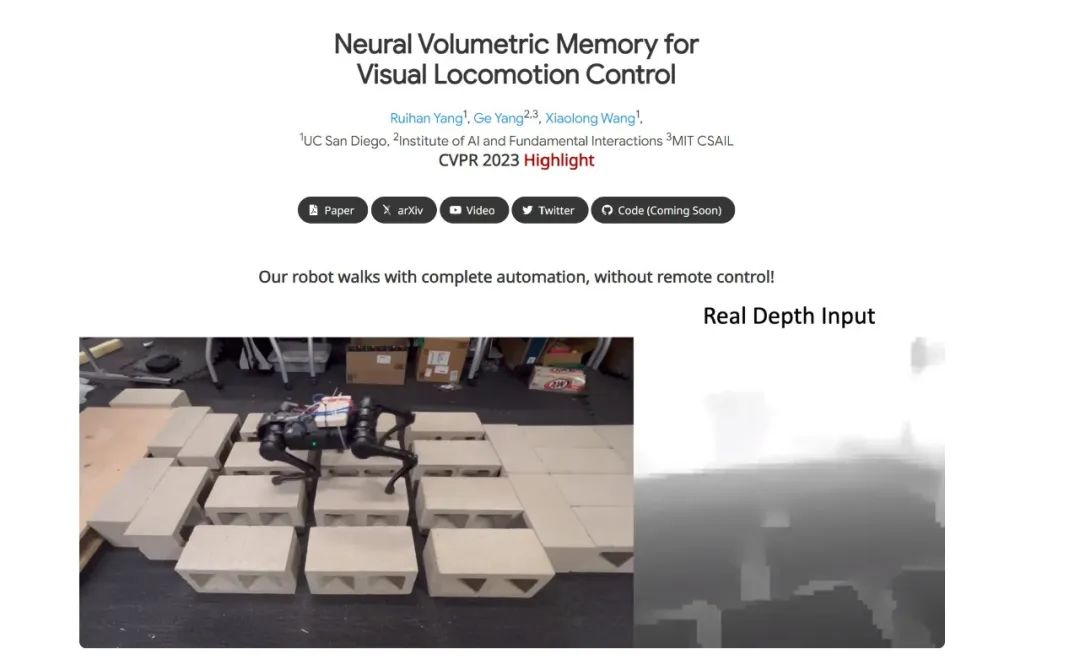

利用这项技术,机器狗学会了感知三维世界,能够通过单一的神经网络实现爬楼梯、跨缝隙、翻障碍等等——完全自主,无需遥控。

▍构建连贯3D场景,解决长期难题

长久以来,机械狗在征服复杂地形的道路上一直是困难重重,传统的方法是基于模型来控制机器人的行动,但是往往无法适应真实世界中的未知环境。

近年来,一些学者开始使用无模型的强化学习方法来训练机器人控制器,可以在模拟环境中训练,然后将学到的策略直接应用到真实机器人上; 但是这种“盲目”的控制器无法感知周围环境,即便加入视觉反馈,也无法在复杂的地形中看到所有的障碍。

要想让机械狗看清更多的障碍物,就需要将它的多个视角组成一个连贯的场景,然而在机械狗的运动过程中,安装在其头部上的摄像机会发生剧烈和突然的位置变化。

为了把这些变化连贯起来,将某单个帧放到正确的位置,就显得非常重要了。

▍AI视觉算法给机械狗开“天眼”?还能自监督学习

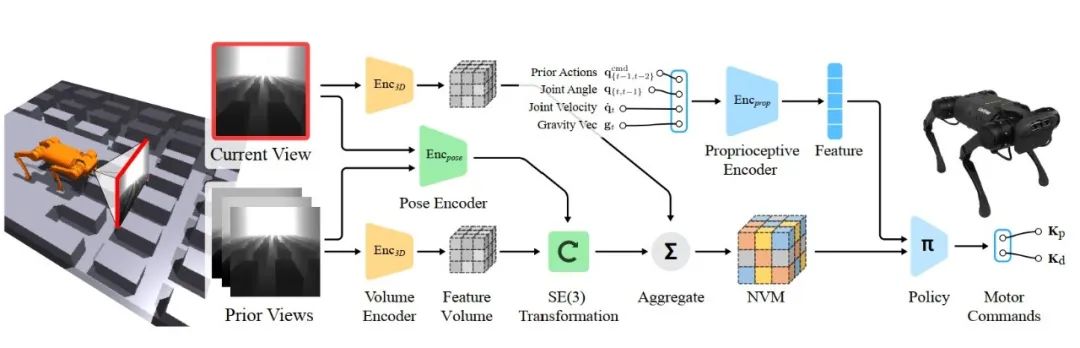

研究人员提出的神经体积记忆(NVM)架构,就是来解决这个问题的。机器人需要从先前的帧中收集信息,并正确推断被遮挡的地形。

具体包括以下几步:

1.通过一个3D编码器在摄像头获取的2D图像中提取3D信息,并转换为3D特征体积;

2.再对“当前帧”和“前几帧”的信息进行比较,估计其中的3D变换,这些信息包括:机械狗腿部的关节角度、关节速度、与地面的距离等;

3.将“前几帧”的特征体积转换到“当前帧”的坐标系中;并把它们融合在一起,就得到周围3D结构的神经体积记忆;

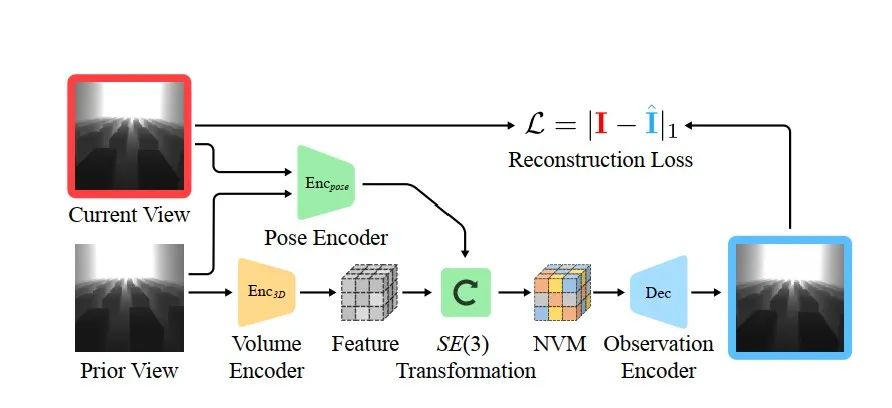

机械狗可以使用当前帧来合成先前的帧。当它移动时,NVM会根据相机已捕获的帧检查合成帧。如果它们匹配得很好,那么NVM就知道它已经学会了 3D 场景的正确表示。否则,它会进行修正,直到正确为止。

除此之外,它还能通过 ⌈自监督学习⌋ 来训练神经体积记忆,研究团队训练了一个独立的解码器,能够观察和两个帧之间的预估转换,从而预测后续的图像。

这样一来,通过综合过去的视觉信息,机械狗就能够记住它所看到的内容以及它的腿之前采取的动作,并利用该记忆来通知它的下一步动作。

解码器的视觉重建

解码器的视觉重建

如上图,第一幅图显示机器人在环境中移动,第二幅图是输入的视觉观察结果,第三幅图是使用3D特征体积和预估画面合成的视觉观察效果。

对于输入的视觉观察,研究团队对图像应用了大量的数据增强来提高模型的鲁棒性。

▍走进现实世界后表现如何?

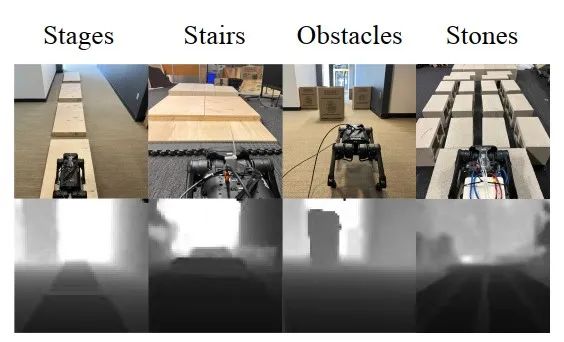

那么在现实世界中,机械狗的表现如何呢?研究人员在室内和室外环境中都进行了测试。

先来个最难的踩矩阵:

使用此前的识别控制技术,小狗直接踩空了,狗头着地:

使用NVM技术后,小狗可以稳稳地走过矩阵:

跨越沟壑,采用之前的技术,小狗后腿对距离判断明显出现了误差,直接摔了个四仰八叉:

使用NVM技术后,安安稳稳通过:

爬楼梯:

走石子路也很顺畅:

发现有障碍物突然出现在自己面前时,直接就会选择绕开:

▍开发者介绍

这项研究由加州大学圣地亚哥分校、人工智能与基础交互研究所、麻省理工学院计算机科学与技术学院的研究人员合作完成,文章标题为“Neural Volumetric Memory for Visual Locomotion Control”。

文章的第一作者为Ruihan Yang,2019年本科毕业于南开大学,目前在加州大学圣地亚哥分校读博士生二年级,导师为Xiaolong Wang教授。

他的导师是Xiaolong Wang教授,也是该研究的通讯及第一作者,目前是加州大学圣地亚哥分校的一名助理教授。他在卡内基梅隆大学获得了机器人学的博士学位,并曾在加州大学伯克利分校做博士后研究。