即将出台的欧盟 (EU) 人工智能法案 (AI Act)是规范人工智能的最实质性立法。经过两年的酝酿,它将根据基于风险的方法对包括自主机器人在内的人工智能应用进行分类,并对其进行相应的监管。 一些应用程序被禁止,而那些被视为“高风险”的应用程序则面临最严格的要求。非高风险应用程序只需遵守透明度义务,但鼓励其遵守《人工智能法案》的道德原则清单并遵循行为准则。

《人工智能法案》的影响将在欧盟以外感受到。它适用于在欧盟运营的所有公司,无论它们位于何处,并且由于“布鲁塞尔效应”,公司最终可能会在欧盟以外的地方遵守欧盟的要求。尽管《人工智能法案》很重要,但直到瑞士圣加仑大学于 2023 年 5 月主办了首届欧盟《人工智能法案》大挑战赛,该法案才得到实地测试。大挑战赛为期100天,包括训练营和两轮决赛,奖金为100000瑞士法郎。团队竞相将《人工智能法案》付诸实践,评估不同人工智能应用与《人工智能法案》草案的一致性。随着媒体和学术界关注大型语言模型和其他形式的生成式人工智能,自主机器人最近逃脱了密切关注,但大挑战强调了嵌入式人工智能,并揭示了人工智能法案的范围、优势和劣势。

新兵训练营于12月30日与ARCHE机器人暑期学校一起举行。团队花了一天时间在瑞士军队救灾训练设施检查机器人,采访从业者,并评估四个应用程序是否符合人工智能法案。每个提供者都做了一个简短的介绍,之后两个小组有 13 分钟的时间提问。这是最后一轮的热身:评估没有被评判,尽管有一份申请延续到一周后在圣加仑大学举行的决赛。决赛也采用了类似的形式,但除了机器人供应商之外,参赛者还听取了医疗保健、电信和制造业另外三家公司的参赛。在下午的演讲结束后,团队必须在第二天早上之前撰写一份11页的报告,评估四个人工智能应用程序是否符合《人工智能法案》——有些是高风险的,有些则不是。决赛第一天结束后,11支队伍被缩小到两支——LegalAIzers 和 Conformity Mavericks——他们在最终评估中正面交锋。

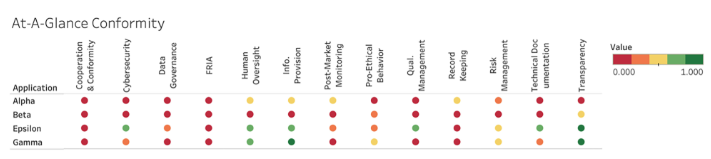

我们的团队事先花了几周时间制定我们的方法,该方法依赖于综合基本权利影响评估 (FRIA) – 数据保护影响评估 (DPIA)。在某些条件下,《人工智能法》草案要求 FRIA 和 DPIA。在三方谈判中,它们的范围正在争论中,但由于它们在风险管理中的效用(另一项人工智能法案要求),我们向所有提供商推荐了它们。我们将《人工智能法案》分解为88项不同的要求,并创建了一个量化的评估机制,该机制被纳入图1所示的图形中。我们的方法在供应商进行合规过程时,根据定量指标为他们提供定性建议。Conformity Mavericks 采用模块化、基于图形的方法进行评估。这两种方法的共同点是认识到,提供者需要有意义的方法来实施《人工智能法案》的高级要求。

值得注意的是,根据《人工智能法案》,遇到的每个机器人都被归类为高风险。尽管《人工智能法案》的高风险应用清单中没有特别提及机器人,但根据欧盟特定行业立法,任何需要接受合格评定的产品的人工智能应用都被归类为高风险。这包括属于《机械法规》的任何内容,其中包括大量机器人,以及在安全组件中使用人工智能的机器人。因此,任何使用计算机视觉进行碰撞检测的自主或半自主机器人都将被视为高风险,并受到《人工智能法案》最严格的规定的约束。

参加大挑战赛的机器人公司大多是初创企业,尽管他们的创始人希望遵守《人工智能法案》,但他们不确定哪些要求适用以及如何满足这些要求。由于不同的法律行为与其自身的技术规范相互作用,这变得更加困难。人工智能提供商必须遵守《人工智能法案》、《通用数据保护条例》(如果处理个人数据)和其他相关立法,对于机器人提供商来说,这些立法可能包括《机械法规》和可能的其他部门立法。因此,机器人在公共场所使用计算机视觉的提供者必须确保人类图像被适当匿名化,但与提供者的问答环节表明,隐私和其他道德问题往往被搁置一旁。当问题复杂、指导稀缺且资源有限时,这是可以理解的。公司,尤其是初创企业,将优先考虑产品开发,而不是建立道德委员会来为一个模糊的目标制定行为准则。《人工智能法案》已经预见到了这一点,并将依靠欧洲机构颁布标准和官方行为准则,但这些尚未发布,使供应商没有明确的前进道路。

人工智能提供商现在需要开始设计合规性,但在没有官方监管的情况下,某些设计理念可以提供帮助。在大挑战赛决赛的第二天,又向评委小组口头介绍了一项人工智能提供商评估。该提供商的一些应用程序是低风险的,免除了它们对《人工智能法案》的大部分要求,因此 LegalAIzers 讨论了支持道德的设计,将其作为实施《人工智能法案》原则的一种方式。道德设计是一种设计理念,专注于通过塑造他们可用的信息而不是他们的选择来赋予人们权力, 推动他们做出更好的选择,但尊重他们做出的任何选择,这可以支持《人工智能法案》所拥护的价值观,例如自主性和尊严。这对于与人类进行切向交互的机器人非常重要,例如公共场所的送货机器人,它们必须应对人们不可预测的运动,并可能鼓励人们给他们更多的空间,以及直接与人一起工作的机器人,例如在制造业中。

最终,评委们宣布这是平局,LegalAIzers 和 Conformity Mavericks 平分了该奖项,该奖项旨在支持正在进行的研究。除了资金之外,团队和人工智能提供商对《人工智能法案》有了新的理解。尽管它相当全面,但问题仍然存在。其中一些与《人工智能法案》试图保护中小企业(SME)有关,所有参加大挑战赛的机器人公司都有资格保护中小企业免受过度负担。在《人工智能法案》草案中,中小企业可以豁免的一项措施是要求就FRIA与受影响的团体进行磋商,但这是促进有用的FRIA和行业道德意识的关键方式之一。其他保护措施似乎是多余的,可能会增加复杂性,例如列出技术文件要求,然后声明中小企业如果得到国家当局的批准,可以使用任何与之相当的东西。“大挑战”中小企业似乎最需要的是关于如何实施抽象法律标准的切实建议。他们中的许多人表示,他们没有必要的法律专业知识来驾驭错综复杂的法规和要求,他们认为他们必须寻求外部帮助,这可能代价高昂。

初创企业(尤其是机器人领域的初创企业)可以帮助减轻中断的一种方式是在整个设计、开发、部署和退役阶段纳入风险管理模型,如 FRIA 和 DPIA。识别和减轻基本权利的风险,特别是数据保护,是《人工智能法案》最具挑战性的方面之一,但从一开始就以设计合规为目标将有助于初创企业避免破坏性的纠正。然而,公司仍然必须遵守技术文档、记录保存、信息提供、人工监督、准确性、质量管理、透明度和上市后监测要求,以及部署第三方人工智能系统的额外义务。这些规定已经明确规定,但尚未标准化,因此,例如,“最先进的”监测需要什么尚不清楚。欧洲议会强调,他们希望保护和促进创新,但最有帮助的不是可能使合规复杂化的豁免,而是具体的指导。

大多数公司要实现完全合规还有很长的路要走,但他们的兴趣和参与不仅仅是打勾。大挑战在机器人领域有着悠久的历史,从DARPA大挑战到10年《科学机器人》中概述的2018个“大挑战”。《人工智能法案》大挑战是第一个关注监管而不是技术的法案。在这样做的过程中,它提供了合规过程的预览,并应在其他立法中效仿。尽管如此,仍需要更多的指导,以便公司,尤其是受交叉法规约束的机器人中小企业,能够合规和创新。企业应从一开始就整合风险管理,考虑采用亲道德设计等设计理念,以避免代价高昂的路线修正,并将道德和法律反思融入整个开发过程。